No início do mês, a Apple anunciou que suas controversas ferramentas para conter a circulação e posse de Material de Abuso Sexual Infantil (CSAM, na sigla em inglês) foram adiadas. Desde os primeiros rumores de sua existência, os mecanismos foram alvos de duras críticas vindas de grupos e entidades especializadas em segurança, mas você sabe por que isso causou tanto barulho a ponto de levar a companhia a adiar a chegada da função? O Canaltech explica.

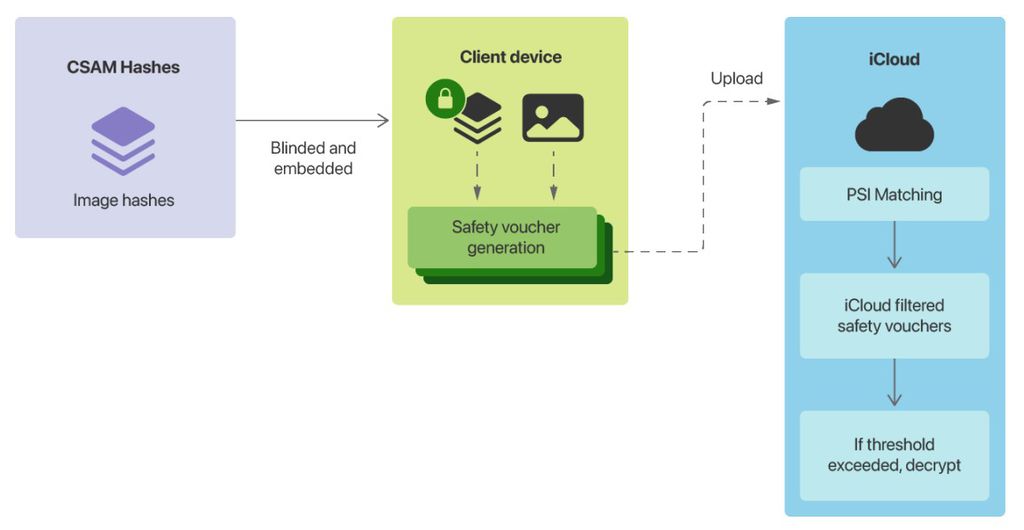

Em agosto, a Apple apresentou formalmente a NeuralHash, uma tecnologia que extrai um número único e exclusivo com base na análise visual de uma imagem. Segundo a companhia, o sistema seria eficiente em encontrar imagens semelhantes ou idênticas, já que dois arquivos apresentariam códigos semelhantes.

A ideia, então, foi adaptada para controlar a posse e o compartilhamento de fotos de abuso sexual infantil. Cada dispositivo Apple — seja iPhone, iPad ou Mac — contaria com o mecanismo, que faria a análise constante de material enviado ao iCloud ou compartilhado pelo iMessage (neste último, somente em contas infantis).

-

Podcast Canaltech: de segunda a sexta-feira, você escuta as principais manchetes e comentários sobre os acontecimentos tecnológicos no Brasil e no mundo. Links aqui: https://canaltech.com.br/360/

-

Os dados obtidos pelo NeuralHash seriam confrontados com a base de hashes do Centro Nacional para Crianças Desaparecidas e Exploradas (NCMEC) dos Estados Unidos. Se várias semelhanças fossem detectadas, uma equipe de avaliação humana seria acionada para confirmar a denúncia e, logo em seguida, encaminhar às autoridades responsáveis. Antes do envio, o usuário poderia contestar a detecção e pedir uma nova avaliação.

Para especialistas em segurança, a notícia foi vista com alarde. Em sua perspectiva, a Apple estaria inserindo um backdoor dentro de cada iPhone com iOS 15 que, além de expor milhões de usuários ao monitoramento automático (e possivelmente também ao manual), abriria portas para interesses mais nocivos, como busca por opositores de governantes mesmo em países ditos democráticos.

Uma das entidades com posicionamento mais forte contra a medida foi a Electronic Frontier Foundation (EFF). O grupo norte-americano admite que a circulação de pornografia infantil é um problema sério, mas que a escolha de implementar mecanismos de detecção automática em tamanha escala “terá um preço alto para a privacidade geral do usuário” e que, mesmo que devidamente explicada, a função não seria nada mais que um backdoor.

“Já falamos antes e diremos de novo: é impossível construir um sistema de varredura local que só pode ser usado para imagens sexualmente explícitas enviadas ou recebidas por crianças”, alerta a EFF, fazendo referência à análise de imagens recebidas no iMessage que, em tese, poderia submeter a análise (humana ou não) de absolutamente qualquer imagem.

“Mesmo um esforço bem-intencionado para construir tal sistema quebrará as promessas importantes da criptografia do próprio mensageiro e abrirá a porta para abusos mais amplos”, complementou a EFF.

Ainda segundo a EFF, não é nem a primeira vez que algo parecido acontece. Anteriormente, uma tecnologia bem semelhante e também pensada para conter pornografia infantil foi utilizada para encontrar “terroristas” — algo bem distante de seu objetivo original. O Fórum Global da Internet Contra o Terrorismo (GIFCT) e companhias envolvidas no projeto poderiam colaborar livremente neste banco de dados para caçar pessoas e banir materiais considerados de cunho terrorista.

O medo, então, reside aí: a Apple pode até afirmar que o programa não será utilizado para nenhum outro fim além do controle de CSAM e que nem governos teriam direito de modificar a ferramenta. Ainda assim, isso não seria suficiente para evitar que o recurso chegasse às mãos erradas e seja utilizado para censura, por exemplo.

Além disso, o NeuralHash está longe de ser perfeito. Por meio de engenharia reversa, o programador Asuhariet Ygvar colocou a tecnologia para funcionar e compartilhou o código no GitHub. Rapidamente, os testes amplos da comunidade revelaram que, além de impreciso, o software acusava CSAM em imagens comuns.

Após tentativas mal-sucedidas de esclarecer pontos e acalmar os ânimos da comunidade especializada, a Apple decidiu recuar. A fabricante adiou a ferramenta de monitoramento “com base no feedback de clientes, grupos de defesa e pesquisadores”. Contudo, a ideia não foi totalmente descartada.

A Maçã entende que a circulação de conteúdo sexual infantil é um problema grave para seu ecossistema — e isso já tem tempo. Em 2020, executivos da companhia já conversavam sobre o assunto e mostraram que a Maçã pensava em soluções que não implicassem na retirada de criptografia de ponta a ponta dos aparelhos.

O iOS 15 deve ser lançado já no próximo evento da Apple, marcado para 14 de setembro deste ano. De primeira, a ferramenta não será equipada no sistema operacional, mas os especialistas em segurança devem continuar bem atentos ao código da atualização para encontrar novos sinais da NeuralHash.

Leia a matéria no Canaltech.

Trending no Canaltech: